Intel ускорила свои видеокарты в CS:GO на 80%

Intel выпустила новый драйвер версии 3953 для своих графических адаптеров, который добавляет нативную поддержку DirectX 9 для некоторых игр.

Если вы вдруг пропустили, то изначально Intel фокусировалась на поддержке DirectX 11 и DirectX 12, а старые API работали в формате эмуляции. Из-за этого в старых играх видеокарты работали гораздо медленнее конкурентов. Однако, на рынке до сих пор есть много киберспортивных проектов, использующих этот древний API.

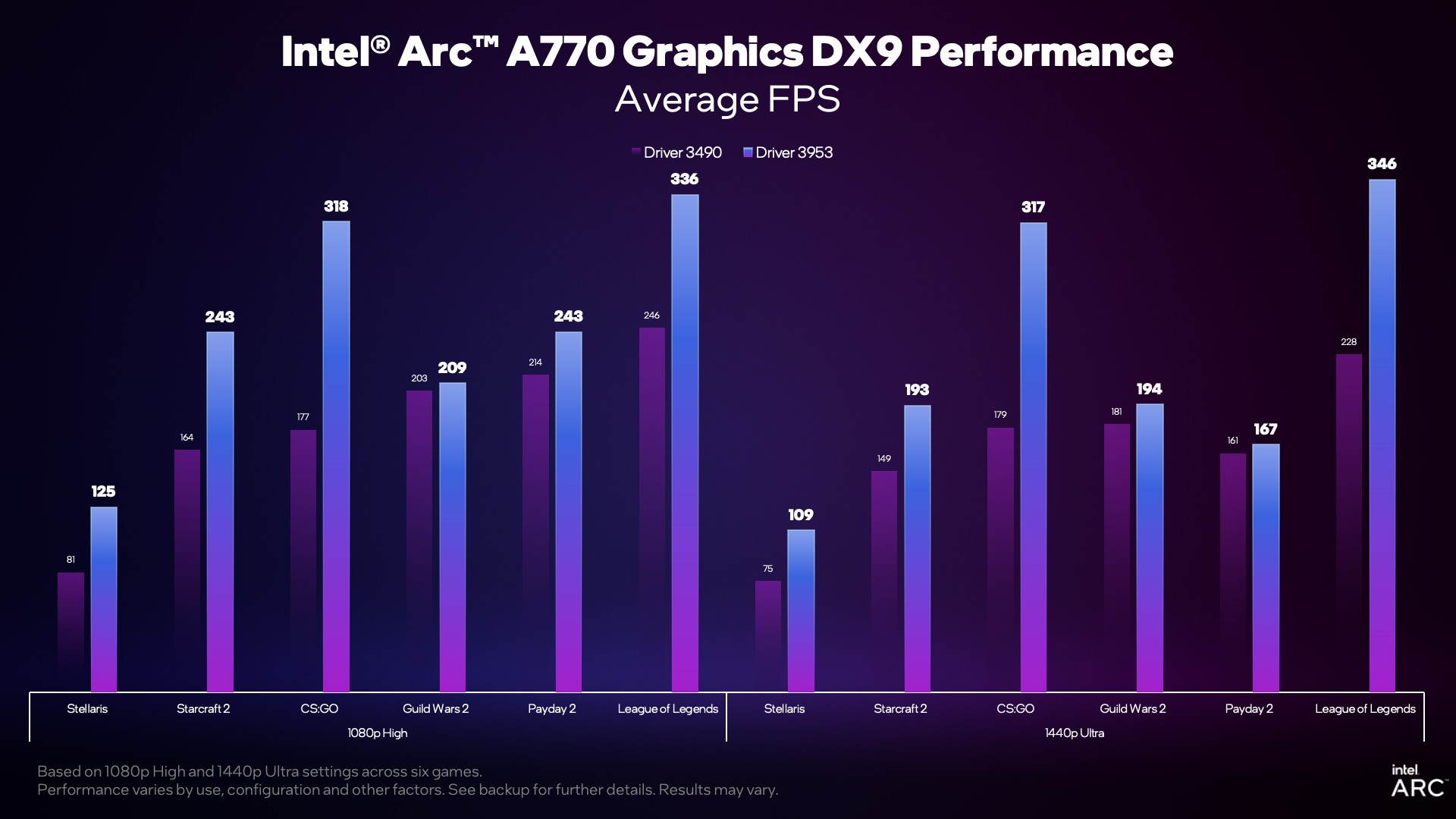

На графике ниже видно, что в некоторых случаях прирост составил 80% (CS:GO, League of Legends).

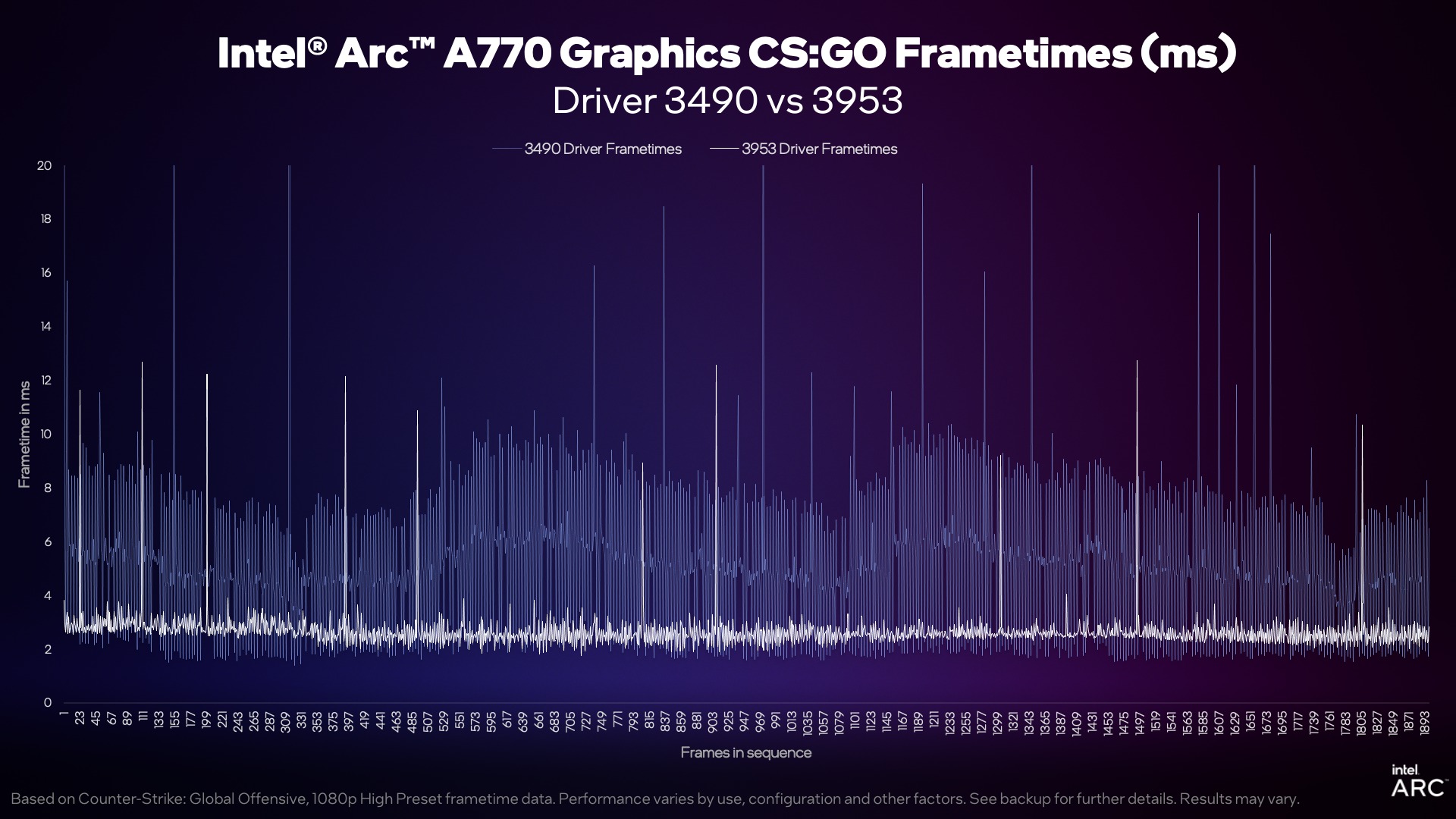

Но дело не столько в производительности, сколько в скорости генерации кадра. Ранее игра работала очень нестабильно — теперь же с этим все в порядке. А минимальный fps в таких играх вырос на значение вплоть до 2,3 раза.

Оптимизации коснулись не только серии Arc, но и встроенных видеокарт.

Новости и статьи по тегам:

- 3 Вышел новый Game Ready драйвер от NVIDIA с поддержкой Zombie Army: Dead War 4 и Metro: Exodus. Sam’s Story

- 13 Первый игровой тест процессора Intel Core i7 9700K

- 37 Новые тесты RTX 4080 – обе карты сильно уступают RTX 4090

- 1 Пошаговую одиночную RPG по вселенной League of Legends перенесли на 2021 год

- 5 Тесты производительности Intel Core i9-11900K и Core i5-11400

- 1 NVIDIA выпустила драйверы с улучшениями для Microsoft Flight Simulator и World of Warcraft: Shadowlands

какой-то странный график… LOL в 1440Ultra (346) фпс больше чем в 1080High (336) да и поднятие с 1080 высокие до 1440 ультра словно бесплатное для этой карты. что-то не сходится тут. может CPU были разные? или еще что

показатель, что Интел утратили “нюх”. Они не понимают, что нужно потребителю, выпыживают продукт для Себя ,а потом в спешке доклепывают то, что нужно было позиционировать как основу…

Майкрософт в свое время тоже профукал свои позиции именно по той же причине — они перестали чувствовать потребности потребителя…

Теперь понятно для чего Интел делала видеокарты, для одной игры

Интел никакой нюх не потеряли, они делали упор на новые игры, а на старых, они посчитали, что много фпс аля 200-300 и не нужно, поэтому была лишь эмуляция. Вполне логичное решение. Особенно учитывая, что основной массе людей больше 60 стабильных фпс нигде и не нужно.

Решение было рискованным, потому что конечно на ютубе появились бы обзоры, где идет сравнение карт именно в старых проектах, и люди подумали бы что в новых все еще хуже. И оно так и произошло. Аналогичная ситуация у nvidia с их LHR люди думают, раз занерфили алгоритм какой то, то и в играх хуже работает. Карты у интела вполне нормальные, просто не универсальные, как мы привыкли.

Я не интел бой если что, сижу на райзене.

@Dusker

Задача Интела — продавать свою дорогую продукцию. Поэтому ничего логичного в потенциальном урезании и игнорировании того, что можно было не урезать и не игнорировать (с учетом, что они все вернули назад), точно так же как ничего логичного не было в заявлении Майкрософта о том, что их Игровая консоль не только и не столько для игры… на фоне Сони — которая прямо сказала, что мы делаем Лучшую консоль для Игр.

Хочешь продать видюху — целовни в попку всех, и тех которые играют в пасьянс и тех , кто молится на FPS-сы. Хочешь продать консоль — оближи геймеров так, чтобы они мечтали получить именно твою железяку.

Я про это.

Может нельзя было? Может это были лишнии финансовые затраты? Или тебе кажется, что они просто взяли и просто так вырезали, потому что им скучно было?

Да, странные ребята из интел)

Бывает бывает, замечал у себя несколько раз, такое возможно когда карта слабо загружена.

если можно поподробнее (что за железо, в какой игре заметил и тд и тп). а то я столько лет ПК пользуюсь и не разу не замечал что бы мой ПК себя так вел. в 1080 на высоких, выдавать меньше ФПС чем в 1440 на ультра

На 3090 не помню, но точно 1 раз замечал, а на 4090 в пауке(моралес), в некоторых моментах было больше в 1440p, чем в 1080p, а разница между 4k и 1080p была совсем небольшая (9900k)

Про 3090, не помню было ли там именно больше fps, вроде просто не было разницы в fps между разрешениями, и этот момент я отметил.

@piton4 в теории, ты можешь получить одинаковый ФПС на разных разрешениях, если: 1. карта спокойно рисует все карды что делает ЦП. 2. игра не слишком сложная для ЦП при разном разрешении. 3. все упирается в ЦП и он просто не может нарисовать больше кадров для карточки

но повторю, я такого не замечал у себя ни разу, да и разных тестах железа не припомню.

@h1pp0 я считаю главное в этом моменте это проц, и возможно от игры зависит(оптимизация и тд). Случай очень редкий, но и такое бывает.

@h1pp0 вот только что спецом решил, по быстрому — Callisto Protocol 1080p GPU 43% — 53fps \ 1440p GPU 52% — 53fps\ 4k GPU 82% — 53fps )) вот так вот

а лок не стоит? странно что у тебя 53фпс, мало как-то

Это у игры такая оптимизация. Уточню, что это в некоторых местах, обычно где много тумана и источников света, в большинстве мест разница всё-таки есть.

@h1pp0 https://drive.google.com/file/d/18Zls5nRDwP3CIZ4952sSvjvzQdGcbDdX/view?usp=share_link

https://drive.google.com/file/d/14ILfIXPA7HSEKrZOHj9iVzJFOt9oVCqr/view?usp=share_link

https://drive.google.com/file/d/14fmr_xzpkhqnierYz2lu_26ZeB-I0EwD/view?usp=share_link

Это уже другое место. Две верхние это 1080p и 1440p, а нижняя 4k. Как видишь между 4k разница здесь уже есть, хоть и небольшая, а вот межу fullHD и 1440p вообще никакой.

А вот пример хорошо оптимизированной игры и без упора в проц.

https://drive.google.com/file/d/1NEVsVN6iW5_G3lZjCbEFEwl6Hgsx64GE/view?usp=share_link

https://drive.google.com/file/d/1v5MjpzOmaVvIuM-QKIEWGyfJfK60tBQ_/view?usp=share_link

https://drive.google.com/file/d/1ChzroHQIm5Tnbm4Pp4rFGEyfC9Glzuix/view?usp=share_link

А бывают настолько странно оптимизированные игры, что в каких-то ситуациях, fps больше в более высоком разрешении.

@piton4 но пресет графики у тебя везде одинаковый, верно? условно высокий или ультра, сути не меняет.

у интел же по мимо разрешения, меняется еще и настройки графики с высоких на ультра. карточке сложнее ультра, даже если убрать из расчет ЦПУ.

ну ладно, забавная ситуация =) пусть будет так

Конечно.