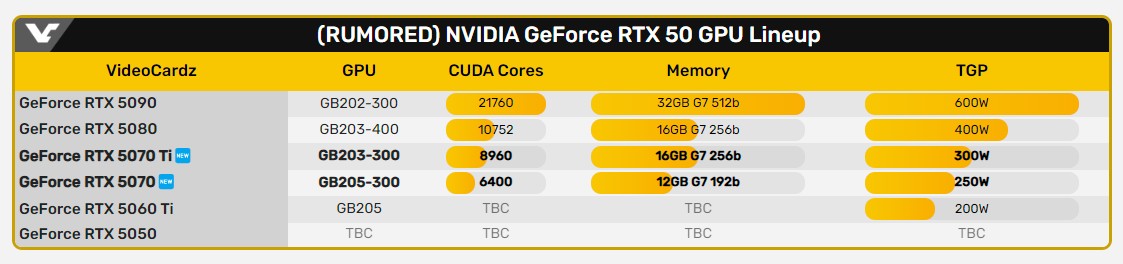

NVIDIA выпустит пять моделей RTX 50 в начале 2025 года

СМИ выяснили, что NVIDIA готовил целую серию видеокарт RTX 50 к релизу в следующем году.

Уже в первом квартале в продажу поступят RTX 5090, RTX 5080, RTX 5070 Ti и RTX 5070, а во втором — RTX 5060 Ti и RTX 5060.

Характеристики RTX 5070 Ti и RTX 5070 появились в сети впервые.

в 23:44 22 ноя 2024

Технические новости

Теги:

rtx

Новости и статьи по тегам:

- 3 Трассировка лучей появится в Hitman 3 уже 24 мая

- 31 В Atomic Heart появилась трассировка лучей

- 12 VideoCardz: RTX 3060 Ti местами значительно обходит RTX 2080 Super по производительности

- 12 NVIDIA ожидает, что до конца года RTX 3080 и RTX 3090 будут в дефиците

- 1 RTX 3090 вряд ли станет выбором для майнеров из-за высоких стоимости и энергопотребления

- 1 NVIDIA выпустила драйверы с оптимизациями для Star Wars: Squadrons и улучшением стабильности для серии RTX 30

.jpg)

600W — вот это печка.

Это уже официальная инфа по характеристикам? То есть дефолтные 600w?! Получается, если в OC-версиях будет как обычно, возможность увеличить PL на 20% то… Это жесть.

Это жесть.

Ну, 5070 (ti) мне бы хватило...

Хватило на что?

Еще лет на пять

4070 в VR не хватает.

в VR не хватает.

Ну за VR я не шарю, но могу сказать, что 4090 “не в VR” не хватает

Ну хз 70тки в 2к без лучей и vr хватает.

Ладно про VR это шутка просто в свое время расстроило что 4070ti Заметно хуже в VR чем 3080.

Ну… без лучей… Без лучей и 4090 хватает почти везде А если 1440p ещё поставить, то 4090 даже с запасом будет. Как всегда, весь вопрос в настройках и желаемом fps.

А если 1440p ещё поставить, то 4090 даже с запасом будет. Как всегда, весь вопрос в настройках и желаемом fps.

оптимист.

Тоже на них смотрю, золотая середина. И мне бы хватило) Но для этого нужны золотые, то есть место, где я могу их взять (где мне их могут дать), ещё и получив от этого удовольствие. Что же это за место…

м… цены подозреваю будут пугающими. Они грозились , что данное поколение будет дороже чем 4ххх , но 4ххх уже не купить без продажи соседа на органы

-

p.s. на самом деле больше интересует, что там АМД замутят. Они солидно обошли интелов почти на всех рынках, получили хорошую прибыль — все шансы забодяжить доступную и хорошую карточку для всех.

что будет в этот раз узким местом? обьем памяти? шина? частота?

После карточек с обрезанным до 8-ми линий pci-e, закономерным будет, что они пойдут дальше и зафигачат длиннющие здоровенные карточки, висящие всего лишь на 4-х линиях pci-e, ну и каким-нибудь очередным экзотичным слотом для питания до кучи.

2070super, играю в 1080р.

Я не гоняюсь за эпическими настройками. Средних мне за глаза.

Цена.

Врят ли. Они официально от гонки отказались сказав что будем конкурировать в среднем сегменте а не в топах. Так что скорее всего выпустят какойнть аналог 7800 на новом поколении. Который будет конкурировать с **70 чуть мошънее и дешевле но без лучей и длсс.

До сих пор хорошая видюха, гонял в тестах с 3060 12 и 4060, 2070s их обеих уделала. Сам сидел не парился а потом поменял монитор на 2к и обломался 2к она не вывозит пришлось менять.

Я лично не сомневаюсь, они могут себе это позволить. Выставят ценник за 5060 с шиной 64бит и 6Гб в 1000уе и скажут: ну мы сделали все, что могли, но не покупают — отменяем все Жифорсы вместо них выпускаем ИИ-ускорители, за одно заработаем очередную сотню лярдов.

GTX — ПЕЧ — это получится если набрать слово GTX в русской раскладке. Как говорится. В этом мире нет ничего случайного.

Что-что, а цена, я думаю, тут будет весьма широкой. Как бы не пришлось ценники на A4 печатать, чтобы все цифры вошли

Да, как выше написал Spy_13, AMD поняли, что в сегменте видях топового сегмента, им зелёных не одолеть, и пытатться больше не станут. А вот в среднем сегменте у них хорошие шансы.

Понятно. Ну если так, то и 4070 наверняка сгодится на следующие 5 лет, тем более если цель 60fps.

Об этом каламбуре известно давно, но есть два нюанса. 1 — Печь пишется с мягким знаком. 2 — Сейчас видеокарты RTX, а значит КЕЧ.

Возможно. Но всегда хочется небольшого запаса который новое поколение обеспечит чуть лучше.

Имхо, на всех вариантах кроме 5090 видеопамяти мало. У старшей модели 32, а у второй по приоритету всё равно 16, как и у последующих, как и у 80-ки предыдущей серии. Неужели нельзя было хотя бы 5080 дотянуть до 24-гигов видеопамяти?

Возможно Хуанг хочет зарядить на 5090 какие-то неадекватные цены, выделить и отделить её ещё сильнее от предтопа, отсюда и 16gb у 5080. Типа целая двукратная разница, как по основным характеристикам, так и по объёму vram. Или он планирует выпустить со временем Ti, в которой и будет 24.

В 99% игр, 16gb хватает с головой. Бывает встречаются очень неоптимизированные, с утечками”, тогда и 24 будут не лишними. Это редкие случаи.

Для игр-то хватает. Но когда я хочу развернуть пайплайн для анализа больших массивов данных из открытых источников, то 16 гигов — это малый объём. Допустим, я периодически обрабатываю большие массивы неструктурированных данных, начиная от текстовых документов и заканчивая медиафайлами. Моя текущая 3080 Ti с 12 ГБ памяти еле справляется с современными задачами. И 16 гигов - это очень маленький отрыв. Особенно с учётом того, что на момент выхода 5080 моей карте будет уже около 5 лет.

Из-за ограниченного объёма видеопамяти приходится дробить датасеты на крошечные части. Для некоторых LLM уже сейчас 16 гигов являются очень маленьким значением. При обучении кастомных моделей для классификации и кластеризации специфичного контента приходится идти на компромиссы: либо уменьшать размер батча и получать нестабильное обучение, либо урезать архитектуру модели в ущерб качеству. С задачами компьютерного зрения всё совсем тяжело: какой-нибудь поиск визуальных дубликатов в массивах фотографий или идентификация лиц даёт адскую перегрузку.

В итоге получается, что для бытовых штуковин с использованием современных инструментов машинного обучения остается только два варианта: либо переплачивать за флагманскую 5090 с 32 ГБ, либо искать компромиссные решения в виде дробления задач или использования менее требовательных, но и менее эффективных моделей.

24 ГБ в гипотетической 5080 были бы идеальным балансом между производительностью и стоимостью.

Уже скоро 2025-й год, и машинное обучение перестаёт быть чем-то эксклюзивным, доступным только лабораториям и крупным корпорациям. Оно становится бытовым инструментом: домашние эксперименты с нейросетями, генерация контента, персонализированные модели — всё это переходит из профессиональной среды в руки обычных пользователей. Как и с 3D-принтерами, которые изначально были доступны лишь крупным предприятиям, теперь возможности машинного обучения стремятся стать доступными каждому.

Но NVIDIA, похоже, не спешит идти навстречу этому тренду. Вместо того чтобы предложить универсальное решение с разумным балансом между мощностью и ценой, компания как будто намеренно создаёт разрыв в своих линейках, вынуждая пользователей либо переплачивать за флагманские модели, либо мириться с ограничениями младших карт. Если машинное обучение — это будущее бытовых технологий, то доступные видеокарты с расширенным объёмом видеопамяти — это ключ к этому будущему. А пока что NVIDIA, похоже, больше заинтересована в максимизации прибыли, чем в том, чтобы стать локомотивом этого прогресса.

А разве для профессиональных задач не берут соответствующее железо? При ваших то расходах на комплектующие уж можно было потратиться и на 4090. Ну или, как минимум, взять 3090(ti).

Так у @0wn3df1x и так 4090 Он же писал характеристики своего компа ценою в 1.5 ляма ) не так давно.

Это не профессиональные, а бытовые задачи. Это такое же нормальное явление, как “умный дом”, все эти “умные помощники”-колонки и прочее. Допустим, самая простая бытовая задача, которая решается методом машинного обучения — у вас на компьютере хранятся десятки тысяч фотографий родственников. С помощью машинного обучения вы можете создать у себя на компьютере базу данных, где будет записано, на каких фотографиях и какие родственники присутствуют. Какой-то родственников почил — теперь можно с помощью этого отобрать фотографии только с ним и затем использовать лучшую фотографию для памятника. И всё это без необходимости использовать облачные сервисы, показывать фото кому-то чужому.

Стоимость профессиональных видеокарт у нас вот такая:

Только зачем профессиональная видеокарта для бытовых задач? 4090 — это флагман, 5090 тоже.

А должен быть вариант, который идёт сразу за флагманом, как в своё время это было с 3080ti.

Однажды вышла обновлённая версия игры Lisa, в которую добавили русский язык.

Но региональная цена для России при этом оказалась очень высокой.

Я написал об этом разработчику, дескать посмотрите на рекомендуемые цены и на вашу цену.

И уже скоро разработчик снизил цену…

...но перед покупкой я дождался скидки на распродаже.

А тут он пишет

Кому верить? @0wn3df1x тогдашнему или @0wn3df1x нынешнему?

Вот это вот все

прям сплошь бытовые “ежедневные” нужды простого обывателя, ага. Вы по себе всех не судите.

Я писал о самом топовом варианте, который может себе позволить тот, у кого очень много денег.

Конечно. Если они есть не у всех обывателей — это естественный процесс диффузии технологий в массы. Как с распространением социальных трендов (вспомнить хотя бы эмо и готов, которые двигались по России неравномерно и возникали в разные годы, с 2005-го до массового 2007-го и 2008-го). Технологические новинки проходят тот же путь.

Двадцать лет назад смартфоны были редкостью, сейчас они есть у каждого школьника. Раньше умные колонки были экзотикой, сейчас это привычный элемент умного дома. Беспроводные наушники с активным шумоподавлением тоже были частью премиум-сегмента, теперь они повсюду.

Это касается и машинного обучения, технологии которого интегрируются в повседневную жизнь. NVIDIA сама активно продвигает бытовые ML-решения: RTX Voice для шумоподавления, NVIDIA Broadcast для стриминга, Chat RTX для локальной работы с LLM. Всё это работает на потребительских RTX картах и становится частью обычного пользовательского опыта.

Есть и другие вполне бытовые задачи — локальная обработка фотоархива (распознавание лиц, автоматическая сортировка), создание персонализированных помощников для умного дома, генерация и обработка контента без использования облачных сервисов, конвертация голоса в текст и обратно. Но с увеличением возможностей растут и требования к видеопамяти.

И те же современные модели становятся всё более требовательными к ресурсам. Даже новые базовые модели Stable Diffusion потребляют дикое количество видеопамяти. А если добавить к ним ControlNet или другие расширения — происходит перегрузка. Локальные LLM тоже "тяжелеют": модели с миллиардами параметров уже считаются средними, а не топовыми.

NVIDIA, предлагая в 5080 те же 16 ГБ, что и в 5070, что и в 4080, словно игнорирует этот тренд. Это как если бы производители смартфонов в 2025-м году выпускали флагманы с 64 ГБ памяти, а все последующие модели имели до 32 ГБ. Технологический прогресс предполагает равномерное масштабирование характеристик по всей линейке. 24 ГБ для 5080 были бы логичным шагом, отражающим реальные потребности пользователей, которые хотят использовать современные ML-инструменты, но не готовы переплачивать за флагман.

Складывается впечатление, что NVIDIA пытается искусственно сегментировать рынок, подталкивая тех, кто использует ML, к покупке более дорогих моделей, что противоречит тренду демократизации AI-технологий, который мы наблюдаем последние годы. Машинное обучение становится таким же базовым инструментом, как офисные приложения или графические редакторы, и видеокарты должны начинать соответствовать этому запросу.

Вы смеетесь что ли? Это ваша аналогия? Вы бы еще сказали, что сто лет назад пользовались дровяным печами, а сейчас имеется централизованное отопление.

И все это и далее описанное нафиг не нужно 70-80% рядовых пользователей ПК.

Аналогия прекрасная. А реакция очень напоминает классическое сопротивление инновациям, которое сопровождает каждый технологический скачок.

В 19-м веке говорили, что телефон имеет слишком много недостатков для серьезного рассмотрения как средства связи. В 20-м говорили, что телевидение скоро провалится, ведь люди быстро устанут смотреть в фанерный ящик каждый вечер. В конце двадцатого вообще дошли до того, что 640КБ памяти хватит для любых задач, больше “нафиг не нужно 70-80% рядовых пользователей”.

Диффузия инноваций, описанная Эвереттом Роджерсом, показывает, что любая технология проходит путь от инноваторов (2.5%) через ранних последователей (13.5%) к раннему большинству (34%). То, что сегодня кажется избыточным для "70-80% пользователей", завтра станет стандартом де-факто.

Когда появился графический интерфейс, многие утверждали, что командная строка справляется со всеми задачами. Когда появился интернет, говорили, что он нужен только учёным. Когда вышли первые смартфоны, уверяли, что обычной звонилки достаточно.

Сегодня мы наблюдаем аналогичный процесс с ИИ-технологиями. Автоматическая генерация изображений, локальные чат-боты и прочее — всё это уже интегрируется в повседневные инструменты. Windows начинает встраивать Copilot, Adobe внедряет Firefly и всё такое прочее.

И точно так же, как в своё время процессоры эволюционировали от простых вычислений к поддержке мультимедиа-инструкций (MMX, SSE, AVX), современные GPU должны развиваться в сторону поддержки ИИ. Это естественная эволюция, отражающая изменение пользовательских потребностей.

Задача технологических компаний — не ориентироваться на текущее большинство, которое "ещё не созрело", а создавать инфраструктуру для будущего. Как в цитате, которую приписывают Генри Форду:

"Если бы я спрашивал людей, чего они хотят, они бы сказали: более быстрых лошадей".

Поэтому да, увеличение объёма видеопамяти в массовых картах — это не прихоть энтузиастов, а необходимый шаг для демократизации ИИ, который уже происходит, хотим мы этого или нет. В дальнейшем те самые "70-80% пользователей" будут активно использовать локальные ИИ-инструменты, даже не задумываясь об этом — точно так же, как сегодня они используют автокоррекцию или поисковые системы.

А вот с этим я могу согласиться. Но мы то говорим о сегодня, а не о завтра. Лет через 10-20 то о чем вы говорите возможно и станет обыденностью. Но не сегодня.

ТАК МНОГО ВОПРОСОВ И ТАК МАЛО ОТВЕТОВ...

FullHD 60 FPS с лучами на максималках без D.L.ASS.ASS и прочего размазанного по монитору мыла с артефактами сжатия будет побежден или надо еще немного пять лет лучей потерпеть, чтобы уже минимальная цена на видеокирпич=5000$ и подключение напрямую в электрощитовую?

Про MSAA когда-нибудь снова вспомнят или это надо уже ждать до MSAA 2.0, когда построят двадцатиэтажные видеоподстанции для 30FPS 720p с DL ASS ASS 8.5?

Тугоумных обезьян на разработчиках в URINAL ENGINE научат отключать обмыливание по умолчанию в своих играх? Их научат хоть когда-нибудь делать нормальные настройки графики в принципе, чтобы 70% параметров потом не пердолилось вручную через конфиг, потому что senior developer — тупоголовый дегенерат, у которого из-за ФГМ спинной мозг взял на себя функции головного или вообще там целая стая подобных сбежавших в АЙТИ лабораторных лоботомированных макак-резусов с выдрессированными “компетенциями” оператора — без намека на логику, понятийный аппарат и творческий ум? Я за всю историю могу вспомнить лишь две игры на URINAL, где можно сразу убрать все ненужное говно — Witchfire и VLADIK BRUTAL. Во втором случае далеко не “ВЫТИРАН ИНДУСТРИИ” сделал больше, чем все разработчики очка игр на этом двигле за все время — он просто сделал НОРМАЛЬНОЕ меню настроек графики. Это что, какой-то дар небес или высшее творение богов, или для этого требуется нанять орду из 100000 лбов разом для одной задачи — сделать нормальное меню настроек графики, чтобы игроку не пришлось лезть в конфиг, чтобы исправлять говно на экране?

Почему за первые 5 лет существования попиксельного освещения и динамических теней видеокарты научились их спокойно тянуть без обязалова тратить 1000 BUCKS со стороны покупателя, а вот лучи все никак-никак, мыла поверх все больше, но цена лишь растет?

Почему вместо увеличения производительности GPU и оптимизации энергопотребления мы получаем ежегодно увеличивающиеся в массе калоблоки в пропорции +1кг+100W+500$ в год напару с новыми версиями растягивателей по экрану артефактов сжатия из пониженного разрешения, которые рекламные шлюхи пафосно называют NVIDIA Deep Learning Super Sampling? (F.ASS.R, X.E.AS.S и прочее).

Почему массы вступают в тоталитарные секты воровских монополистов-дебилизаторов и слепо верят их прикормленным педерастезированным модным шлюхам, что пропагандируют деструктивные идеи, типа: “у вас картинка мыльная, потому что вам просто нужен 4К\8К\16К монитор! Мы вам тут игры делаем с расчетом на 4К МИНИМУМ, а свои лоховские 1920x1080 давно на помойку выбросьте!” А на чем я это 4\8\16К буду включать, если у меня в FullHD на GAY FORCE ANUS TRAYCING 4090 пожар в квартире из-за прогара нового удешевленного разъема и идущих к нему тонюсеньких проводков как в наушниках, а 60 кадров без мыла даже нет? Почему около прорывному для своего времени первому FEAR для всей красоты нужна была затычка из жопы бомжа на 128 мегабайт для получения нативной картинки без намека на мыло и говно, на актуальных и даже более тогда мониторах 800х600, 1024х768, 1280х720, 1280х1024, 1440х900? А что если же включить новомодные CUMTROL или ANAL LAKE 2 на всех эти распердоленных лучах, то я увижу абсолютно нереалистичное дерьмо вместо света, его преломления и отражения поверхностями, которое выглядит как рябящее мыло с артефактами\гостингом, а чтобы оно запускалось, нужно поверх размазать еще оним слоем мыла с артефактами в виде слоя DLASSASS или подобного, чтобы мне высрало РЕКОНСТРУИРОВАЛО кадр из разрешения 320х240 в 3840х2160? А в fullHD уже нельзя — у нас тут текстурки для таких низких разрешений не разрабатывались!!! А еще видеокарты с 8 гб уже МАЛО, хотя в fullhd никогда и ничего не съест больше 6 гб, а для 4К 12 гб будет с запасом. Как бы все эти RTX 4000-5000 подтверждают, ведь 12+гб только в топе, а “народный” бомжовский сегмент все еще с 4-6-8 гб, если брать в расчет плюсом AMYDE. Почему сегодня в так называемых AAAAAAAnal-проектах на лучах вместо отражений в зеркале матовый куб без текстуры со сплошной заливкой, а в доисторических, вроде severance BOD, херачили сразу вторую локацию в луже, чтоб правдоподобно и не нужно было никаких лучей и пятикилограммовых RTX-кирпичей? От этого ведь отказались, потому что РЕСУРСОЕМКО! Так может эта гомосексуалировка бичей — никакая не аппаратная и вовсе не ресурсозатратная технология, как ее пиарят, а вместо всяких ТЕНЗОРОВ и RT-ЯДЕР - обычная растеризация и картельный сговор с целью получения сверхприбыли в виде пустых квадратов на кремнии, на которые не затрачены деньги при производстве? Почему УНИКАЛЬНУЮ DL ASS ASS только для RTX при помощи обычных модов смогли заставить работать на любой карте?

Почему каждое следующее “покаление” видеокирпичей все дешевле в себестоимости производства, что влечет за собой снижение качества, т.е. потребительских характеристик (отказоустойчивость, долговечность), но цена при этом лишь растет? Почему двадцатидолларовая видеокарта с завода на выходе стоит 1000-1500$? Тут для сравнения можно посмотреть “эволюцию” (инволюцию) продуктов APPLE: как год от года при постоянном росте цены оно превращается в залепленный спермоклеем кусок пластика без намека на качество (отказоустойчивость, долговечность, практичность, функциональность).

Все эти вопросы — риторические. Ответы на них давно даны и вполне очевидны.

Всем спасибо — я покакал текстом как за два дня сразу. Вообще не понимаю, зачем вы это читали от начала и до конца.

еще больший оптимист)

Это мне говорит человек, играющий на 1060 в 2024 году.

@Сильвер_79 поэтому и говорю.

я пожалуй за красных и пшик эти ваши лучи

Интересует полный обзор RTX 5090 и её тесты, на максимальных настройках, в играх.

Согласен Только без всякой вот это шелухи, типа FG, DLSS. В нативе, с трассировкой и без.

Только без всякой вот это шелухи, типа FG, DLSS. В нативе, с трассировкой и без.

Какая будет разница в сравнении с 4090

Именно — интересна честная мощь.

А потом выйдет что-нибудь вроде Alan Wake 2, и разрабы пояснят, что “нужно просто принять и полюбить эти замечательные технологии. И отключить их нельзя, кстати, так что наслаждайтесь нашим отполированным продуктом!”

Ну если умельцы могут имплементировать dlss туда, где его официально не должно быть, то уж отключить его точно смогут )

>12-16gb

Ясно.

Удачи оптимистам, снова купившим хх70. Удивительные люди.

Ждем 8800xt за 600 баксов.

Давайте пока до выхода PS6 не будем ничего ждать, думаю и зеленые и красные представят что то стоящее только после выхода новых консолей, хотя у меня вот интерес ради интереса это то какие получатся “боевые маги” у Интела