AMD анонсировала видеокарты серии RX 6000

На сегодняшней конференции AMD анонсировала несколько видеокарт, созданных на архитектуре RDNA 2. Корпорация уверяет, что на ней же работают ускорители в Xbox Series S/X и PlayStation 5, хотя насчет последней у независимых экспертов есть сомнения.

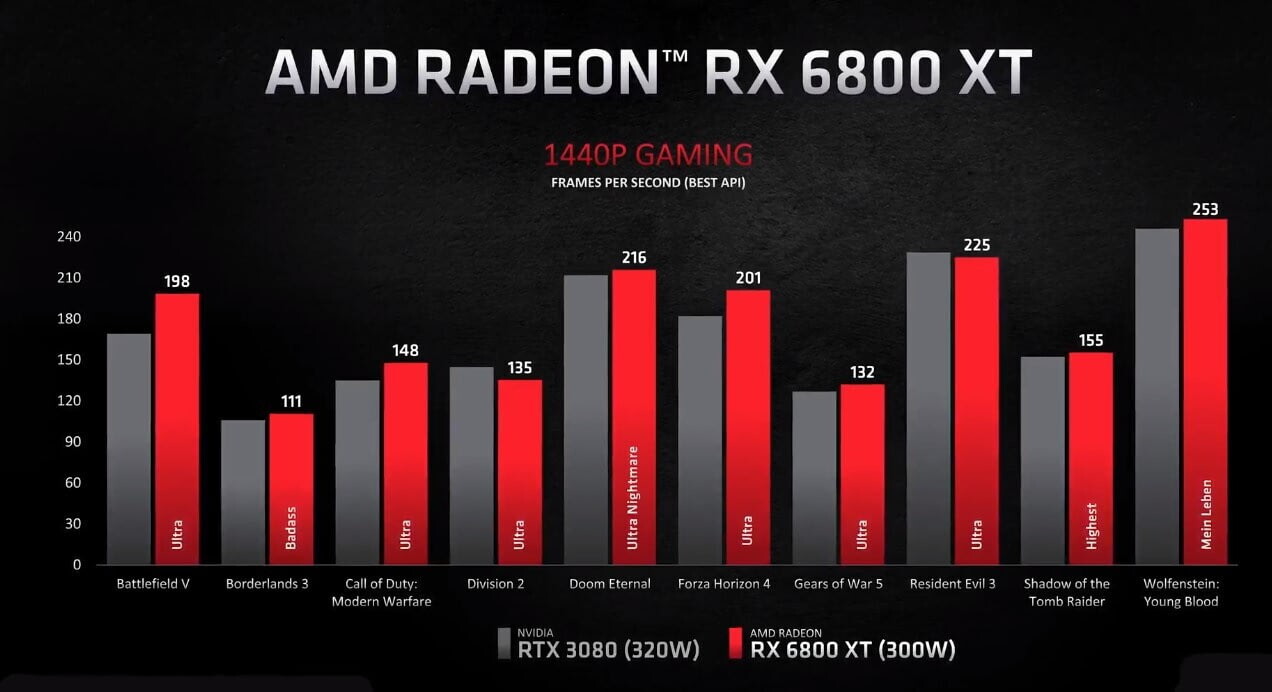

Карты Radeon серии RX 6000 разрабатываются на техпроцессе 7 нм — AMD очень гордится тем, что они потребляют меньше энергии, чем конкуренты от NVIDIA. Например, у Radeon RX 6800 XT — 300 Вт, у RTX 3080 — 320 Вт.

До конца года в магазинах появится три новые модели:

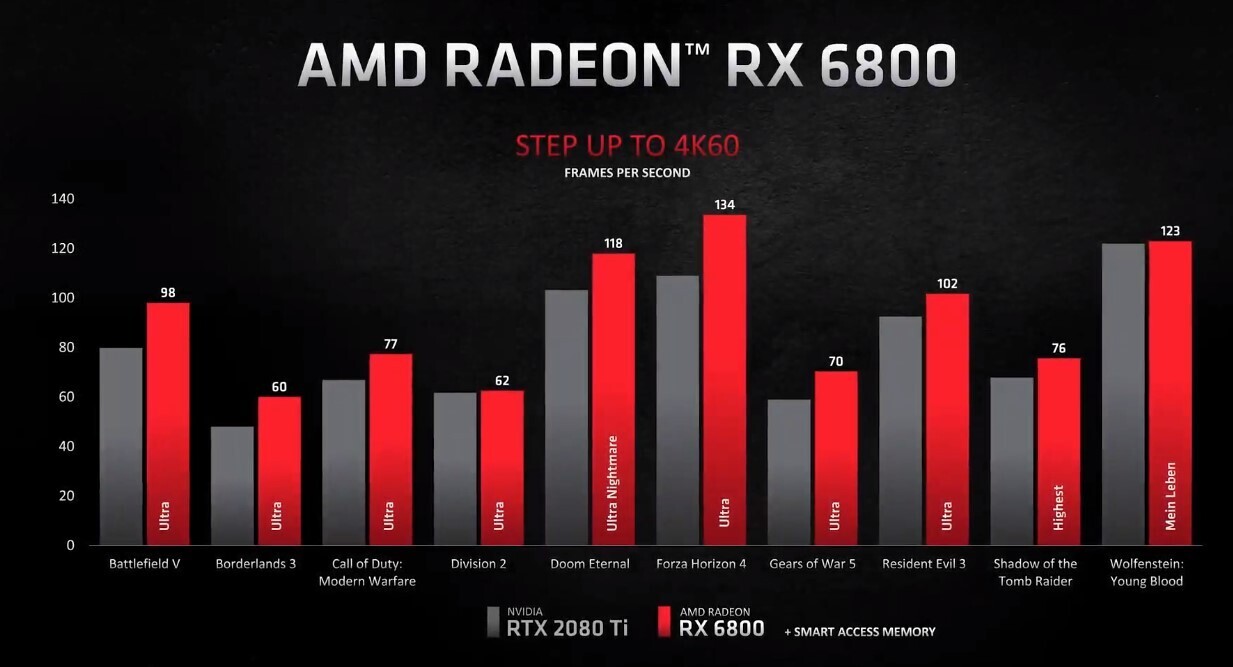

- Radeon RX 6800 — 18 ноября, $580 | конкурент — RTX 3070 — стоит $499

- Radeon RX 6800 XT — 18 ноября, $650 | конкурент — RTX 3080 — стоит $699

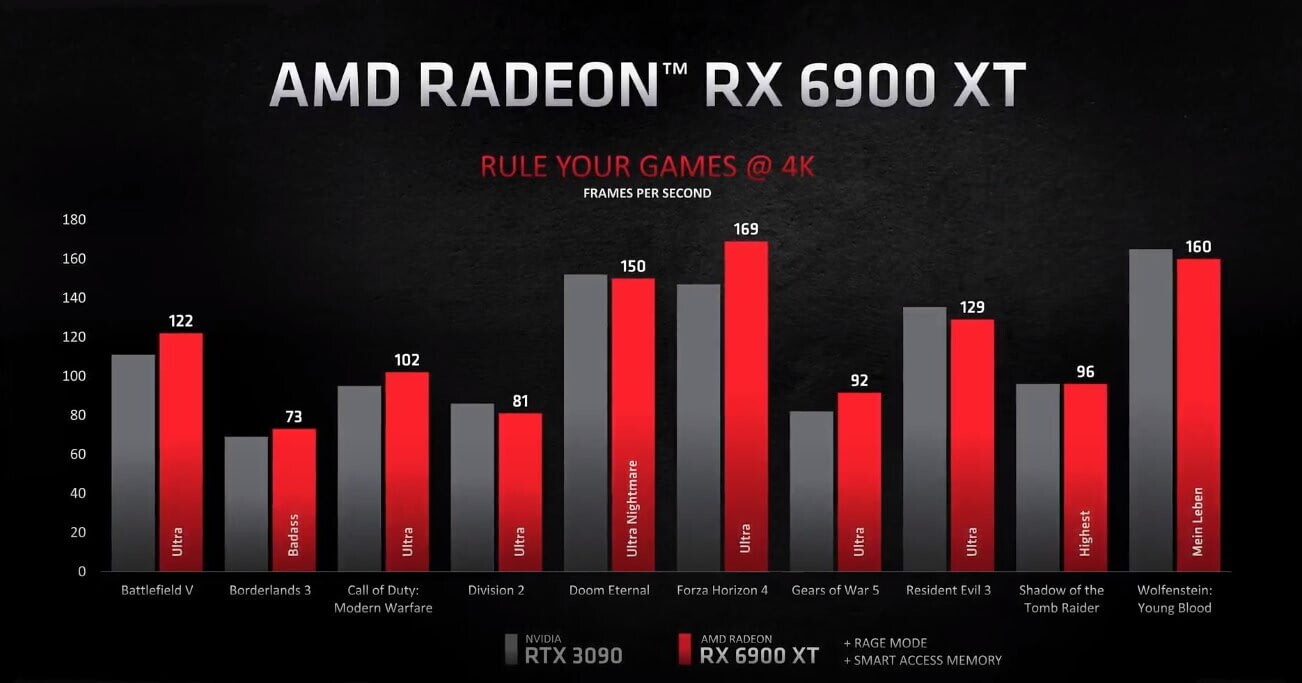

- Radeon RX 6900 XT — 8 декабря, $999 | конкурент — RTX 3090 — стоит $1499

Серия RX 6000 поддерживает рейтрейсинг из DirectX 12 Ultimate, пока разработчики явно не торопятся работать с ним. Аналог DLSS находится в разработке.

Также в новых картах появится две приятные технологии: Rage Mode позволит автоматически разгонять видеокарту и снижать задержку ввода, а Smart Access Memory открывает процессорам Ryzen прямой доступ к видеопамяти. Все они работают без необходимости поддержки со стороны разработчиков, в отличие от аналогов от NVIDIA.

Тесты:

Запись трансляции:

Новости и статьи по тегам:

- 92 AMD представила видеокарту среднего ценового сегмента Radeon RX 6700 XT

- 15 Первые тесты Radeon RX 6700 XT: полный провал в рейтрейсинге и уверенные результаты без него

- 88 AMD анонсировала видеокарты Radeon RX 7900 XTX и Radeon RX 7900 XT — старшая почти вдвое дешевле, чем RTX 4090

- 23 AMD показала преимущество новых карт перед NVIDIA в Battlefield 5, Doom Eternal, Shadow of the Tomb Raider и Modern Warfare

- 12 Первые фотографии и тесты Radeon RX 6600 XT – конкурента RTX 3060 Ti

- 49 Перекупщики консолей и видеокарт рассказали, как работает этот бизнес в России

6800 — 580$? Может 480$? Слишком дорого. Или будут менее производительные версии по соответствующим ценам?

Конечно будут, 6700/6600/6500 представят позже.

6800 я так понял по мощностям аналог 3070, которая тоже с 2080Ти сейчас на равных бодается. Но у 6800 вдвое больше памяти, с другой стороны.

Считаю что эти технологи должны быть прям зашиты в драйвера видеокарт и использоваться в любой игре, ибо эта штука мега супер охриненная, если у амд не будет ничего подобного то это печаль беда.

так это функция не поднимающая качество игры, а для увлечения производительности в больших разрешениях.

Проблема? Ты её видишь ? видимо, это значит, что она есть. Ну-у сообщение вообще то быстрее пишется, чем поиски в много минутном видео.

? видимо, это значит, что она есть. Ну-у сообщение вообще то быстрее пишется, чем поиски в много минутном видео.

DLSS очень пропиаренная технология, меньше бы маркетологов слушали ))) амд молодцы))) жду от сапфира 6900 хт нитро плюс

да я от тебя другого и не жду. Главное чтобы ты удовольствие получал, как от прохождения Death Stranding. Остальным не перетруждай себя, пусть за тебя другие ищут

Понятия не имею где взяли вы эту картинку товарищ и делаете ли вы выводы только по ней, но я пересмотрел кучу видео про длсс 2.0 на экран 55” в 4к и разница если и была заметна то только при увеличении объектов на стоп кадре, а при активной игре разницы практически не замечал. у меня возникло подозрение что вы просто придираетесь)

У АМД проблема с нагревом? иначе зачем в видеокарты закладывать аж 3-и кулера. … будет прогресс в 4-ре кулера?

… будет прогресс в 4-ре кулера?

@Star_Wiking т.е. 300вт АМД против заявленых 320 нвидиа вас не смущает? вы видели карты нвидии в 4 слота? вы в курсе, что чтобы 3080 не тротлила и не скидывала частоты нужны карты с потреблением 450 вт? в противном случае она будет дропать частоты до 1665 мгц https://youtu.be/nQyTelAfM_Q и лишь420+вт более-менее держат частоты https://youtu.be/3ScE31lemgQ и вот как выгляди одна из не тротлящих 3080 https://youtu.be/Z3LdASGH1nc?t=91

АМД браво, кастраты 10 гиговые и раньше то не нужны были, а теперь как и было ожидаемо уже начали сливаться, в ватч догс легион уже не хватает 10 гигов, фризы до 22 фпс https://youtu.be/Ux6Wa0rZFa8?t=1416

чего нет на 24 гигах 3090 минимум 45фпс https://youtu.be/nWogai4XFG8?t=1633

:рукалицо:

игра даже еще не вышла а вы хотите чтоб все работало идеально. Назовите хоть одну, новую игру, работающую идеально с самого релиза (чтоб ни багов, ни лагов, ни визуальных казусов)?

@Star_Wiking текстуры ухудшать они не будут, хочешь красиво — бери карту с нормальным объемом памяти или скручивай настройки сам ухудшая качество текстур. хуанг по своей традиции продавать одно и то же 2 раза тоже выпустит карты с адекватным объемом памяти. 8 и 10 гиговые кастраты были обречены изначально так и задумывались, чтобы их побыстрее сменили.

да ладно … а куда вы дели видеокарты с 2, 4 и 6Гб видеопамяти? и много ли сейчас даже видеокарт с 8гб?

Видел я тесы радеончиков с 16гб и как в некотрых играх забивалось 10+ гб видеопамяти … тот-же ФарКрай 5 или Ларка … без проблем играл в эти игры и ваще не ощущал что где-то и как-то, в геймплее, мне мешало малое количество видеопамяти. Как 4гб на 970 так и 6гб на 2060 … вот нисколечко. По 3-4 часа за “сессию”. Чем там игры забивают память мне наплевать … пусть хоть всю игру туда пихает. Работает без сбоев, лагов, багов и ладно.

з.ы. Steam. Видеопамять.

1024 MB - 11.00%

2047 MB - 12.33%

4095 MB - 17.25%

6143 MB - 22.24%

8191 MB - 23.51%

11263 MB - 4.32%

остальные - 3.27%

т.е. примерно 2\3 видеокарт с памятью менее 8гб.

@Star_Wiking в статистике стима большинство компов офисные/ноутбучные для пасьянса и ксочки. а чтобы не видеть фризы на 6 гиговом кастрате 2060 надо быть просто слепым. я 2080 вернул обратно тупо потому что фризила когда упиралась в свои 8 гигов, а 2080 ти слишком оверпрайснута для меня была.

А вот на какой видеокарте стоит остановиться подробнее, так это на GeForce RTX 2060. Данный ускоритель получил отменный графический чип TU106. Вы посмотрите на средний фреймрейт в играх — он везде перевалил за 60 кадров в секунду. Однако в пяти играх из десяти наблюдаются просадки FPS, связанные с заполнением VRAM видеокарты. И это при использовании очень быстрого комплекта оперативной памяти в тестовом стенде.

Много это или мало? Здесь, уважаемые читатели, вы должны решить сами. Мое мнение — этого достаточно для того, чтобы заявить: 6 Гбайт видеопамяти для ААА-игр в разрешении Full HD не хватает уже сейчас. Знаете, обидно купить видеокарту за 25-30 тысяч рублей — и в итоге снижать качество графики, хотя со средним FPS все в порядке. Такое поведение, полагаю, можно простить GeForce GTX 1060 6 Гбайт, которая вышла почти три года назад, и GeForce GTX 1660 — потому что она стоит заметно меньше GeForce RTX 2060. Ну или Radeon RX 570 4 Гбайт, которую в немецком магазине Computeruniverse можно приобрести за 7 500 рублей без учета доставки, а в России — за 10 000 рублей. Ты берешь вещь — и сразу же понимаешь, что в определенных приложениях придется снижать качество графики в лучшем случае до параметра «Высокое».

Когда вы покупаете видеокарту, сколько вы планируете ее эксплуатировать? Наверное, устройство уровня GeForce RTX 2060 должно служить верой и правдой геймеру хотя бы 2-3 года. Только вот в разрешении Full HD память «две тысячи шестидесятой» заполнена на 80 % и более в шести случаях из десяти. Я очень сомневаюсь в большом запасе прочности GeForce RTX 2060 и других Turing-аналогов с аналогичным объемом видеопамяти.

Таблица со структурированными данными по тому, сколько видеопамяти нужно для того или иного разрешения или качества графики, сразу предупреждаю, носит условный характер. Я не раз упоминал, что производительность в играх зависит не только от объема VRAM, но и от многих других элементов персонального компьютера. И все же одним из главных итогов статьи является тот факт, что современная игровая видеокарта, обеспечивающая комфортный FPS в разрешении Full HD при высоких и максимальных настройках качества графики, должна обладать 8 Гбайт видеопамяти. И речь сейчас идет не только про нынешнее время, но и про небольшой задел на будущее. Ключевое слово здесь — «небольшой», потому что тесты наглядно показывают, что многие современные ААА-проекты стабильно потребляют больше 5 Гбайт VRAM, но есть релизы, которым не хватает даже 8 Гбайт.

«Выкрутил все на максимум и радуется тормозам в играх — тоже мне тестер», — обязательно напишет кто-нибудь в комментариях к этой статье. Свою позицию по этому поводу я уже высказал. Еще раз: большинство видеокарт, участвующих в тестировании, выдают высокий средний FPS при заданных мной настройках качества графики. Особенно это касается GeForce RTX 2060, которая «обскакивает» и GeForce GTX 1070 Ti, и Radeon RX Vega 56. Но вот с минимальным FPS наблюдаются явные проблемы, причину которых я уже объяснил.

https://3dnews.ru/987345/skolko-videopamyati-neobhodimo-sovremennim-igram

вы владелец и активный пользователь 6Гб видеокарты? если нет то кусок статьи стороннего сайта не аргумент. Тем более что являюсь активным пользователем и на опыте все обстоит совсем иначе. Так что прекращайте писать о том чего не знаете.

И да, я не являюсь адептом выставления всех настроек “в пол, до упора”. Есть настройки графики с мизерным визуалом но сильно завышенными влияниями на видеопамять и скорость работы самой видеокарты. Они есть и Ларке и Фаркрае и Одиссее. В любой игре.

@Star_Wiking

ну с этого и надо было начинать что скручиваете настройки. качество текстур первое и самое заметное, что бросается в глаза в любой игре, и они никак не влияют на фпс до тех пор пока влезают в видеопамять.

текстуры ставлю на ультра, везде, модели на максимум — везде. А вот к примеру облака на градацию ниже т.е. не “ультра”, а “высоко”, на глаз разницы нет совсем. Тени не “ультра”, а “высоко” — разница визуала минимальна. А фпс выше.

Просто идете на компромиссы из- за нехватки мощности карты

Наличие памяти видеокарты тут не главное. Скорее из-за “старенького” процессора. (проц до 100% доходит, видеокарта до 90%)

К слову, у меня с самого старта не было никаких проблем с Horizon Zero Dawn и Borderlands 3, на которые большинство жаловались. Обе покупал по предзаказу, играл сразу в момент выхода. Правда в Horizon до патчей поиграл только на первой открытой локации, в Borderlands 3 же пробежал за неделю всю сюжетку. Видеокарта — Gigabyte GeForce GTX 1070 Mini 8GB

что-за бред вы несете? комплекс “средние настройки” совсем не то что вы выбираете и настраиваете игру под себя.

С такими настроями зачем вы вообще покупали Нвидиа видеокарту. Надо было брать “святую” Лизу Радеоновну и молится на нее. По крайней мере не придется сидеть с лупой и выискивать исчезнувщую “искру”, эффект, попавшую под “нож” DLSS. Падающие снежинки еще не считали, в том-же Метро? А то вдруг и там оно их “пожрало”.

Метро не нравится? А что на счет Контрол? там тоже эффекты исчезают с DLSS? Или сложно принять что та игра, где у вас DLSS “съела” искорки кусок неоптимизированного дерьма? У вас есть факты подтверждающие данную проблему с DLSS во всех играх(!!!) где оно (сглаживание) присутствует? или балабол?

я просто еще раз повторю для чего и почему эта технология нужна. для увеличения производительности в больших разрешениях, на пример у меня игра в 4к идет скачками в 40-45кадров включаешь длсс и играешь со стабильными 60фпс тем более технология улучшается. Если у вас игра без всяких длсс работает в том диапазоне кадров что вас устаревает то ясен пень его включать ненужно.

АМД и нагрев уже давно стали синонимами. Разве что на своих процессорах им удалось охладить трахание.

P.S. Бесконечно можно смотреть на три вещи: как горят пердаки и течёт слюна у фанатиков AMD

У меня была gtx 550ti — грелась до 80 градусов. Сейчас Rx 570 4gb — греется до 70 градусов, но я добавил ещё один вентилятор. Как по мне, более-менее одинаково греются.

как вы можете сравнивать температуры когда они зависят от мощности, в электронике тепловыделение 99% от энергопотребления. т.е. если карта жрет 300 вт то система охлаждения эти 300 вт тепла и должна рассеивать. в этом поколении АМД официальные спеки 300 вт у нвидии 320 — при одинаковом радиаторах нвидиа будет горячее. про карты АМД еще ничего не известно, зато известно что, чтобы 3080 не тротлила она должна жрать 420-450вт. вот и думайте какие керогазы вышли амперы. не каждый корпус потянет вывести 400 вт тепла только от одной видеокарты.

А коэффициент полезного действия ты куда дел, теоретик? Нахватаются верхушек и начинают умничать

Нахватаются верхушек и начинают умничать

ну это уже дело личное и я все же настаиваю что эта технология очень годная, даже на rtx3090 чтобы поиграть на ультрах при 45-50фпс приходится включать длсс.

Я даже больше скажу, там не 99%, а практически 100%, т.к. кпд практически равно 0.

Вот ролик если интересно:

У вас образование ЕГЭ, как я понимаю? Если у видяхи КПД 0-1%, то зачем её использовать как видеоадаптер, если можно использовать как обогреватель помещения. 99-100% преобразования электроэнергии в тепло — это идеальный показатель электрообогревателя.

Не интересно Образование вы тоже на ютубе судя по-всему получали.

Образование вы тоже на ютубе судя по-всему получали.

У меня нет этой игры (а учитывая что игра только только поступила в продажу) чтоб проверить как обстоит дело.

Т.е. то что игра вышла сырой и не оптимизированной вам как-то в голову не пришло? Как там с патчами дело обстоит — было или еще только готовится? Вы теперь всюду будете благоволить криворуким разработчикам считая что “оптимизация игр “прошлый” век, не держитесь за него”?

з.ы. Выход “ремастера” Crysis вас ничему не научил, к котором 2080ti “задыхалась”?

з.ы.ы. И как люди умудряются играть на 2060, это-же невозможно. Тесты с сайтов не врут.

Я не застал ЕГЭ, т.к. его ввели после того, как я закончил универ.

А с чего вы взяли, что видяха в 300 Вт будет эффективней предназначенного для обогрева устройства, к примеру в 2 кВт, имеющего гораздо большую рабочую поверхность? И зачем в серверных дата центрах проектируют системы вентиляции и кондиционирования, не для того ли, чтобы помещения не превратились в парилку?